Что такое Deepfake и является ли он угрозой?

Это вполне ожидаемо, особенно после выхода серии удивительно реалистичных видеороликов, связанных с различными знаменитостями, говорящими довольно-таки противоречивые вещи.

Данная технология действительно удивляет людей и создает огромное количество вопросов, и именно поэтому мы решили рассказать, что же такое Deepfake, как он работает, а также какие таит опасности.

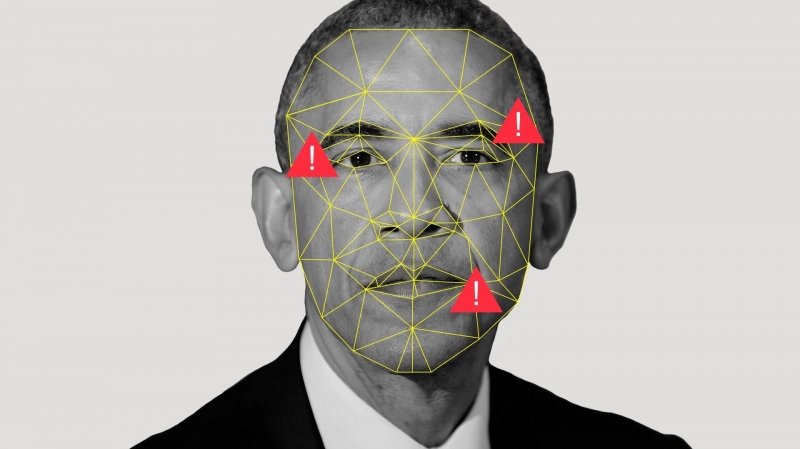

Что такое Deepfake?Deepfake – методика синтеза изображения, основанная на искусственном интеллекте (ИИ). Она использует машинное обучение для создания или управления каким-либо контентом. Технологию часто используют для создания фотомонтажей или наложения лица одного человека на другое, но её возможности выходят далеко за рамки этого. У методики есть множество других применений: например, управление или создание звука, движения, ландшафта, животных и т.д.

Как работает Deepfake?Deepfake-контент создается с помощью метода машинного обучения, известного как GAN (генеративно-состязательные нейросети). GAN используют два алгоритма: генератор и дискриминатор, которые постоянно «соревнуются» друг с другом.

Генератор все время пытается создать изображения, а дискриминатор — отвечает за поиск отличий между ними и настоящими образцами. В случае если второй алгоритм обнаруживает подделку, изображение отправляется обратно первой для усовершенствования. Этот цикл может продолжаться до бесконечности, пока изображение, видео или звук не перестанут восприниматься как фальшивые.

История DeepfakeСамым первым Deepfake видео было порно! Отметим, что довольно-таки часто можно было увидеть, как лица различных знаменитостей накладывались на актрис фильмов для взрослых. Стоит также вспомнить о мемах про Николаса Кейджа, которые были очень популярны.

Впервые о Deepfake как о серьезной угрозе заговорили еще в 2017 году, и все благодаря пользователю Reddit с ником Deepfakes. Он, а затем и другие пользователи, создавали Deepfake-порнографию, из-за чего субреддит был заблокирован.

Настоящим же создателем генеративно-состязательных нейросетей является Ян Гудфеллоу. Он впервые представил концепцию Монреальскому университету в 2014 году, вместе со своими коллегами. Затем он перешел на работу в Google, а в настоящее время работает в Apple.

ОпасностиДа, в различных манипуляциях с контентом нет ничего нового, но дело в том, что раньше для этого требовались серьезные навыки. Прежде всего нужно было иметь мощный компьютер и действительно вескую причину (или просто огромное количество свободного времени) для создания поддельного контента.

Программное обеспечение для создания Deepfake, такое как FakeApp, является бесплатным, его легко найти, и оно не требует огромной вычислительной мощности компьютера. А поскольку инструмент выполняет всю работу самостоятельно, то не нужно быть опытным редактором или кодером, чтобы создавать дипфейки, которые выглядят очень реалистично.

Вот почему широкая общественность, знаменитости, политические организации и даже целые правительства стран обеспокоены столь ярым развитием дипфейков. В плохих руках технология может быть использована для фальсификации гораздо большего, чем глупых мемов про Николаса Кейджа. Представьте, что кто-то создает фейковые новости или инкриминирует видео-доказательства. Также стоит напомнить об уже упомянутых фейковых порнороликах.

Еще одна причина для беспокойства, связанная с дипфейком, заключается в том, что с его помощью знаменитости также могут отрицать свои прошлые действия. Поскольку deepfake-видео выглядят очень реалистичными, любой может заявить, что настоящий клип – это подделка.

РешенияНесмотря на то, что фальшивый контент очень похож на оригинальный, зоркий глаз все же может обнаружить дипфейк-видео, стоит лишь внимательно присмотреться. Беспокоит, однако, то, что в какой-то момент в будущем мы не сможем заметить разницу.

Twitter, Pornhub, Reddit, Facebook, YouTube и другие сервисы пытались и обещали избавиться от такого контента. Что касается более официальных структур, то управление перспективных исследовательских проектов Министерства обороны США (DARPA) сотрудничает с различными исследовательскими институтами и университетом Колорадо, чтобы создать способ обнаружения дипфейков. Конечно, компания Google Alphabet также работает над программным обеспечением, которое может помочь эффективно идентифицировать подобный контент. Alphabet называет этот сервис Assembler.

Кроме того, правительство США было очень обеспокоено Deepfake контентом в преддверии уже завершившихся президентских выборов. Фальшивые видео и изображения действительно могли вызвать переполох среди избирателей. Особенно во время пандемий, мировой напряженности и очень противоречивых политических идей.

На самом деле в США всерьез намерены бороться с фейковым контентом. Например, штат Калифорния присоединяется к усилиям по борьбе с технологией Deepfake, выпустив несколько законов. Губернатор штата подписал законопроекты AB-730 и AB-602: первый защищает политиков от фальшивых видеороликов, которые могут представить их в ложном свете; второй защищает жертв от создателей порнографических видео, которые могут использовать их лица в своих целях.

Пока у нас не появится более совершенное программное обеспечение, которое может обнаруживать нарушения в видеороликах подобного типа, лучшее, что мы можем сделать — быть более наблюдательными и менее доверчивыми.

В конце концов, найти по-настоящему действенный способ в борьбе с Deepfake не очень-то и просто. Совсем недавно Facebook провел конкурс Deepfake Detection Challenge. Программное обеспечение, набравшее наибольшее количество баллов, смогло достичь только 65% точности. Как видите, перспективы очень туманные.

Популярные Deepfake-видеоПопулярнейший американский актер и комик Джордан Пил создал этот ролик вместе с Buzzfeed, чтобы призвать общественность не верить всему, что можно увидеть. Видео показывает Барака Обаму, бывшего президента США, который говорит вещи, которые он никогда бы не сказал, даже называя Дональда Трампа «полнейшим говнюком». Затем авторы ролика показывают, что Обама не совсем тот, кем является, и что видео является представителем Deepfake, но очень реалистичным!

Дальше, эксперт в области интернет-манипуляциям Клэр Уордл показывает нам, насколько реалистично могут выглядеть эти видео, изображая Адель в течение первых 30 секунд видео. Это видео от The New York Times дает хорошее представление об этой теме.

Следующее видео показывает некоторые из самых популярных фальшивых роликов. Здесь можно увидеть множество отличных примеров того, как люди могут быть обманутыми.

Вам нравится сериал «Рик и Морти»? Судя по всему, бывший президент США Джон Ф. Кеннеди считает, что нужно быть настоящим умником, чтобы понять мультфильм. Независимо от того, согласны вы с ним или нет, можно усомниться, что настоящий президент действительно смотрел современный мультсериал.

Последний ролик действительно забавный, но очень нелепый. Тем не менее он выглядит реалистично, несмотря на то, что абсолютно не имеет смысла. Но это видео отлично демонстрирует все возможности технологии Deepfake.

Источник: androidauthority.com